作者:老余捞鱼

原创不易,转载请标明出处及原作者。

写在前面的话:深度强化学习(DRL)可谓是优化股票交易策略的前沿技术。上个月我曾撰写过一篇介绍该技术的文章,不过对部分读者来说可能稍显困难。所以,今天特意为大家准备了一篇入门级的文章,带您一同了解强化学习(RL)在股票交易中的应用。文中,我还特别准备了一些颇具影响力的研究论文,供您进一步拓展学习。最后,我会通过 Python 代码示例,助您轻松入门。

在不断发展的股票交易世界中,寻找制胜策略就像大海捞针。但是,如果您可以使用人工智能领域的强大工具就会让这项任务变得更容易,下面我们一起进入正题。

一、什么是强化学习?

强化学习是一种机器学习,其中代理通过执行操作并从其环境中接收反馈来学习做出决策。

与监督学习(模型在标记数据上进行训练)不同,RL 是通过反复试验来学习的。代理与环境交互、做出决策并从结果中学习,以随着时间的推移改进其策略。

在股票交易中,这意味着使用 RL 通过不断学习过去的交易并适应新的市场条件来制定和完善交易策略。

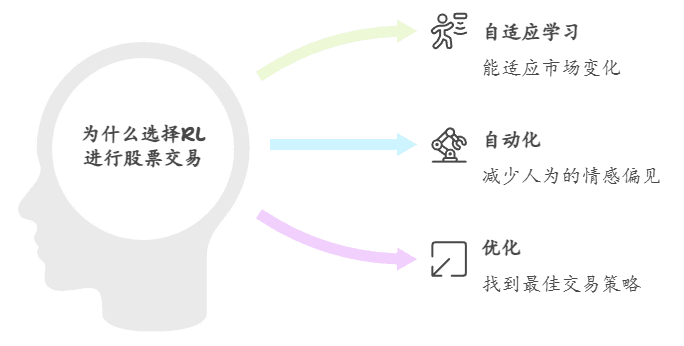

二、为什么要使用强化学习进行股票交易?

以下是 RL 非常适合股票交易的几个主要原因:

- 自适应学习: RL 算法可以通过学习最近的数据并相应地调整策略来适应不断变化的市场条件。

- 自动化: RL 可以自动化交易决策,减少人工干预的需要并最大限度地减少情感偏见。

- 优化:通过不断探索和利用不同的策略,RL 可以找到传统方法可能错过的最佳交易策略。

三、股票交易强化学习的关键研究

为了了解 RL 如何应用于股票交易,我推荐大家有空可以阅读下这五篇在本领域有影响力的研究论文:

- 《 股票交易中的深度强化学习》:本文讨论了利用深度强化学习技术,通过模拟交易环境和使用复杂的神经网络进行决策来改进股票交易策略。

阅读地址:Deep Reinforcement Learning for Stock Trading - 《 利用强化学习的自适应股票交易》: 探讨利用强化学习调整市场变化的自适应交易策略,深入探讨强化学习如何提高交易绩效。

阅读地址:Adaptive Stock Trading with Reinforcement Learning - 《强化学习在金融领域的应用研究》:全面介绍强化学习在金融领域的应用,包括股票交易和投资组合管理。

阅读地址:A Survey on Reinforcement Learning in Finance - 《算法交易中的强化学习:概览》: 综述各种强化学习方法及其在算法交易中的应用,讨论在该领域使用强化学习的优势和挑战。

阅读地址:Reinforcement Learning for Algorithmic Trading: A Survey - 《探索强化学习在金融市场预测中的应用》: 研究如何将强化学习用于预测金融市场趋势和改进交易策略。

阅读地址:Exploring Reinforcement Learning for Financial Market Prediction

四、如何在股票交易中实施强化学习

让我们使用 Python 和 Q-learning 算法(一种流行的 RL 技术)进行股票交易强化学习的基本实现。

4.1 设置

首先需要安装所需的库,使用 pip 执行此操作:

pip install numpy pandas matplotlib gym4.2 定义环境

我们将使用一个简单的股票交易环境,代理可以买入、卖出或持有股票。

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import gym

class StockTradingEnv(gym.Env):

def __init__(self, data):

super(StockTradingEnv, self).__init__()

self.data = data

self.current_step = 0

self.action_space = gym.spaces.Discrete(3) # Buy, Sell, Hold

self.observation_space = gym.spaces.Box(low=0, high=1, shape=(len(data.columns),), dtype=np.float32)

def reset(self):

self.current_step = 0

return self.data.iloc[self.current_step].values

def step(self, action):

self.current_step += 1

done = self.current_step >= len(self.data)

reward = 0 # Define your reward logic here

next_state = self.data.iloc[self.current_step].values if not done else None

return next_state, reward, done, {}4.3 实施 Q-Learning

使用 Q-learning 算法来训练我们的代理。

import random

class QLearningAgent:

def __init__(self, action_space, observation_space, alpha=0.1, gamma=0.99, epsilon=0.1):

self.action_space = action_space

self.observation_space = observation_space

self.alpha = alpha

self.gamma = gamma

self.epsilon = epsilon

self.q_table = np.zeros((observation_space.shape[0], action_space.n))

def choose_action(self, state):

if random.uniform(0, 1) < self.epsilon:

return self.action_space.sample()

else:

return np.argmax(self.q_table[state])

def update_q_table(self, state, action, reward, next_state):

best_next_action = np.argmax(self.q_table[next_state])

td_target = reward + self.gamma * self.q_table[next_state, best_next_action]

td_error = td_target - self.q_table[state, action]

self.q_table[state, action] += self.alpha * td_error4.4 训练代理

在股票交易环境中训练 Q-learning 代理的代码。

def train_agent(env, agent, episodes=1000):

for episode in range(episodes):

state = env.reset()

done = False

while not done:

action = agent.choose_action(state)

next_state, reward, done, _ = env.step(action)

agent.update_q_table(state, action, reward, next_state)

state = next_state

# Load your stock data

data = pd.read_csv('stock_data.csv') # Replace with your dataset

env = StockTradingEnv(data)

agent = QLearningAgent(env.action_space, env.observation_space)

train_agent(env, agent)五、其他注意事项和提示

将强化学习应用于股票交易时,考虑以下方面对于提高策略的有效性和稳健性至关重要:

5.1 数据质量和预处理

数据质量会显著影响强化学习模型的性能。确保您的股票市场数据干净、准确且经过适当的预处理。这可能包括:

- 处理缺失值:填充或插入数据集中的缺失值。

- 规范化:对特征进行规范化或标准化,以确保模型达到最佳性能。

- 特征工程:创建有意义的特征,例如移动平均线、波动性指标和交易量。

5.2 奖励功能设计

奖励功能(函数)是强化学习的核心,可以极大地影响学习结果。设计奖励函数以符合您的交易目标。例如:

- 基于利润的奖励:根据交易的盈利或亏损来奖励代理人。

- 风险管理:对高风险交易施加处罚,以确保交易平衡。

5.3 探索与开发

平衡探索(尝试新策略)和利用(使用已知的成功策略)至关重要。epsilon -greedy策略通常用于管理这种平衡。随着训练的进展,您可能希望降低探索率以更多地关注利用。

5.4 算法调整

微调 RL 算法可以提高性能。尝试使用不同的超参数值,例如:

- 学习率(alpha):控制多少新信息覆盖旧信息。

- 折扣因子(gamma):确定未来奖励的重要性。

- Epsilon:选择随机动作(探索)的概率。

5.5 回测

在实际交易中部署强化学习策略之前,请使用历史数据对其进行广泛的回测,以评估其性能。这有助于确保该策略稳健且不会过度拟合训练数据。

5.6 风险管理

实施风险管理策略,防止重大损失。头寸规模、止损订单和分散投资等技术可以帮助有效管理风险。

5.7 持续学习

金融市场瞬息万变,不断发展。定期使用新数据重新训练 RL 模型,确保您的 RL 模型持续学习和适应。这有助于模型保持相关性并响应不断变化的市场条件。

六、观点总结

强化学习是优化股票交易策略的强大工具,它为自适应、自动化且高效的交易决策提供了无限可能。借助 RL,交易者能够制定出可从经验中汲取养分、适应市场变化,并有望提升交易绩效的策略。通过持续学习和恰当的风险管理,您便能借助 RL 的威力,做出更为明智的交易决策,实现自己的财务目标。

- 强化学习在股票交易中的应用:强化学习能够帮助交易者制定出自适应、自动化且有效的交易策略。

- 与传统监督学习的区别:RL不需要标注数据,而是通过与环境的互动来学习和优化策略。

- 自适应学习和自动化决策:RL算法能够根据市场变化自动调整交易策略,减少人为干预和情绪偏差。

- 关键研究成果:文章列举了多项研究,这些研究展示了RL在金融领域的潜力和应用实例。

- 实施Q-learning的步骤:通过Python代码示例,展示了如何构建RL环境并使用Q-learning算法进行训练。

- 实用建议:强调了数据质量、奖励函数设计、算法调整等关键因素对于RL模型性能的重要性。

- 风险管理和持续学习:提倡通过风险管理策略和持续学习来提高模型在动态市场中的稳健性和适应性。

感谢您阅读到最后,希望本文能给您带来新的收获。祝您投资顺利!如果对文中的内容有任何疑问,请给我留言,必复。

本文内容仅仅是技术探讨和学习,并不构成任何投资建议。

Be First to Comment